Una vez que hemos calculado los estimadores de la Función de Regresión Muestral, es decir, y

sabiendo que estos cálculos están basados en una muestra, debemos ser cautelosos con las afirmaciones que derivan a partir de dichos estimadores, es por esto que debemos determinar una forma de medir qué tan confiables son estos cálculos.

También pudiera interesarte

¿Qué es un intervalo de confianza?

Habiendo definido el error estándar como una herramienta para medir qué tan precisos son nuestros estimadores, resulta intuitivo, definir un entorno en el que viven nuestros estimadores basado en el error estándar. Generalmente, esto se hace considerando intervalos centrados en el estimador de longitud igual a dos, cuatro y hasta seis veces el error estándar, esperando que este intervalo contenga el verdadero parámetro (de la Función de Regresión Poblacional) con un cierto grado de confianza.

Recordando que al contar únicamente con muestras, los verdaderos parámetros de la Función de Regresión Poblacional son desconocidos, consideremos particularmente, que queremos determinar qué tan cerca está el estimador del verdadero parámetro $\beta_i$, para esto se consideran dos números positivos

y

(

) de modo que la probabilidad de que el intervalo aleatorio

contenga al verdadero

sea igual a

, es decir,

A partir de esta igualdad podemos identificar algunos elementos:

es el intervalo de confianza y este intervalo pudiera no contener al verdadero valor.

Los extremos del intervalo de confianza se conocen como límites de confianza, donde es el límite de confianza inferior y

es el límite de confianza superior.

es el coeficiente de confianza, en la práctica,

suele expresarse en forma porcentual como

.

es el nivel de significancia, en la práctica,

suele expresarse en forma porcentual como

.

El nivel de significancia también es conocido como la probabilidad de cometer un error tipo I. Recordando que

- un error tipo I consiste en rechazar una hipótesis verdadera

- un error tipo II consiste en no rechazar una hipótesis falsa.

En el segundo panel se lee: Usted no está embaraza.

Intervalos de confianza de los estimadores

Considerando el supuesto de que los residuos siguen una distribución normal, podemos concluir que los estimadores de Mínimos Cuadrados Ordinarios

y

son en sí mismos normalmente distribuidos con sus medias y varianzas correspondientes. Sabiendo esto, podemos definir una variable

distribuida normalmente con media cero y varianza igual a uno, de la siguiente forma:

Así, se puede utilizar la distribución normal para hacer afirmaciones probabilísticas sobre , siempre que se conozca la verdadera varianza poblacional

.

Si se conoce , una propiedad importante de una variable normalmente distribuida con media

y varianza

es que el área bajo la curva normal entre

es cercana a 68%, que entre

es alrededor de 95%, y que entre los límites

el área es cercana a 99.7%.

Pero pocas veces se conoce el verdadero valor de y, en la práctica, está determinada por el estimador insesgado

. Entonces, si en nuestra variable estandarizada Z, se reemplaza

por

, tenemos que

Es posible demostrar que la variable , así definida, sigue la distribución

con

grados de libertad. Por consiguiente, en lugar de utilizar la distribución normal, se puede utilizar la distribución

para construir un intervalo de confianza para

de la siguiente forma:

donde es el valor de la variable

obtenida de la distribución

para un nivel de significancia de

y

grados de libertad; a menudo se denomina el valor crítico

a un nivel de significancia

.

Considerando , podemos considerar el siguiente intervalo de confianza.

Intervalo de confianza para

Considerando la ecuación

Podemos manipular algebraicamente, para obtener que

Esta ecuación proporciona un intervalo de confianza para de

, que se escribe en forma más compacta como

Calculamos los límites de confianza en R usando la siguiente sintaxis:

li.beta2 <- beta2 - qt(1-alpha/2, df=length(X)-2)*ee.beta2

ls.beta2 <- beta2 - qt(1-alpha/2, df=length(X)-2)*ee.beta2Intervalo de confianza para

Considerando la ecuación

Podemos manipular algebraicamente, para obtener que

Esta ecuación proporciona un intervalo de confianza para de

, que se escribe en forma más compacta como

Calculamos los límites de confianza en R usando la siguiente sintaxis:

li.beta1 <- beta1 - qt(1-alpha/2, df=length(X)-2)*ee.beta1

ls.beta1 <- beta1 - qt(1-alpha/2, df=length(X)-2)*ee.beta1Intervalo de confianza para

Considerando el supuesto de que los residuos siguen una distribución normal, podemos concluir que la variable

sigue la distribución con

grados de libertad. Por lo tanto, con la distribución

se establece el intervalo de confianza para

Donde y

son dos valores de

(los valores críticos

) obtenidos de la tabla chi cuadrado para

grados de libertad de manera que ellos cortan

de las áreas de las colas de la distribución

.

Sustituyendo por

y operando algebraicamente en la inecuación, tenemos que

que da el intervalo de confianza a para

.

li.var <- (n-2)*sigma2.e/qchisq(alpha/2,df=length(X)-2)

ls.var <- (n-2)*sigma2.e/qchisq(1-alpha/2,df=length(X)-2)Ejemplo

Consideremos un pequeño conjunto de datos, particularmente, los datos que se encuentran en la Tabla 3.2 del libro de Econometría de Damodar N. Gujarati and Dawn Porter en su quinta edición. Este conjunto de datos proporciona los datos primarios que se necesitan para estimar el efecto cuantitativo de la escolaridad en los salarios:

| Observación | Salario | Escolaridad |

| 1 | 4.4567 | 6 |

| 2 | 5.77 | 7 |

| 3 | 5.9787 | 8 |

| 4 | 7.3317 | 9 |

| 5 | 7.3182 | 10 |

| 6 | 6.5844 | 11 |

| 7 | 7.8182 | 12 |

| 8 | 7.8351 | 13 |

| 9 | 11.0223 | 14 |

| 10 | 10.6738 | 15 |

| 11 | 10.8361 | 16 |

| 12 | 13.615 | 17 |

| 13 | 13.531 | 18 |

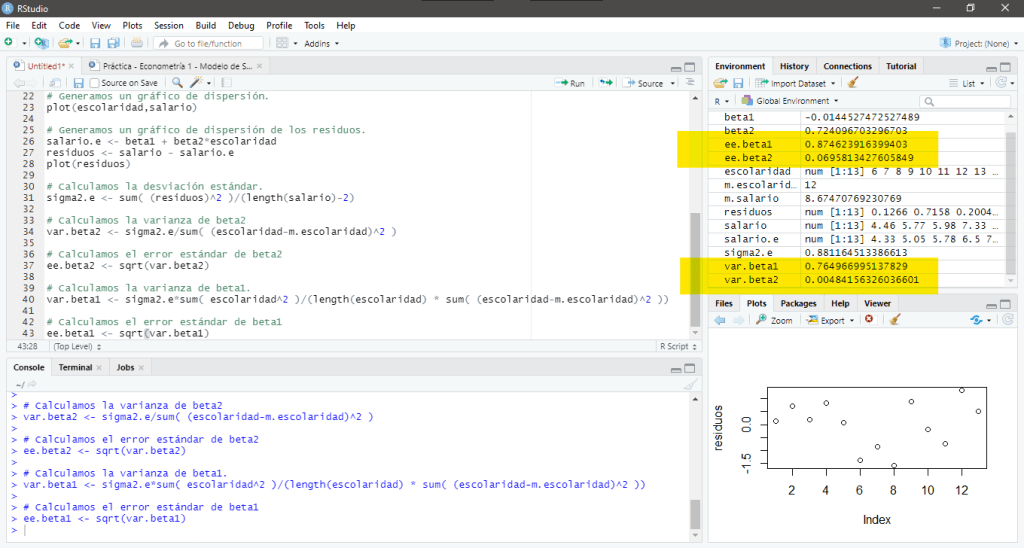

Una vez que hemos calculado el modelo lineal que define este conjunto de datos y en consecuencia, los parámetros estimados. Con un nivel de significancia de 5%, es decir, , podemos calcular los intervalos de confianza de ambos estimadores y además, el intervalo de confianza de la desviación estándar estimada, para esto, usamos la siguiente sintaxis:

# Nivel de Significancia

alpha <- 0.05

# Intervalo de Confianza de beta2

li.beta2 <- beta2 - qt(alpha/2, df=length(escolaridad)-2,lower.tail=F)*ee.beta2

ls.beta2 <- beta2 + qt(alpha/2, df=length(escolaridad)-2,lower.tail=F)*ee.beta2

# Intervalo de Confianza de beta1

li.beta1 <- beta1 - qt(alpha/2, df=length(escolaridad)-2,lower.tail=F)*ee.beta1

ls.beta1 <- beta1 + qt(alpha/2, df=length(escolaridad)-2,lower.tail=F)*ee.beta1

# Intervalo de Confianza de sigma2

li.sigma2 <- (length(escolaridad)-2)*sigma2.e/qchisq(alpha/2,df=length(escolaridad)-2,lower.tail=F)

ls.sigma2 <- (length(escolaridad)-2)*sigma2.e/qchisq(1-alpha/2,df=length(escolaridad)-2,lower.tail=F)Al ejecutar estas instrucciones obtenemos que el intervalo de confianza del parámetro es igual a

y por lo tanto, concluimos que la probabilidad de que el intervalo (aleatorio) que allí aparece incluya al verdadero es de 0.95,

Al ejecutar estas instrucciones obtenemos que el intervalo de confianza del parámetro es igual a

y por lo tanto, concluimos que la probabilidad de que el intervalo (aleatorio) que allí aparece incluya al verdadero es de 0.95.

Al ejecutar estas instrucciones obtenemos que el intervalo de confianza del parámetro es igual a

y por lo tanto, concluimos que la probabilidad de que el intervalo (aleatorio) que allí aparece incluya al verdadero es de 0.95.

En su pantalla debería aparecer:

Debe estar conectado para enviar un comentario.